dataset¶

文本¶

load_dataset (“imdb”)¶

imdb 是 IMDb 电影评价数据集,用于情感分类任务。

它包含来自 IMDb website 的 50,000 条影评,分为 25,000 条正面评论和 25,000 条负面评论。

这个数据集的主要特点和应用如下:

数据来源:IMDb 网站用户提交的影评。

任务:二分类任务,判断评论的情绪取向是正面还是负面。

数据格式:每个样本包含文本影评和一个标签 (正面 1 或负面 0)。

规模:总共 50,000 条样本,25,000 条每个类。

功能:可用于训练评价情感分类模型,检测文本中的情绪倾向。

使用:调用 load_dataset ("imdb") 可加载整个数据集到内存中进行模型训练。

应用:情感分析、评论分类、情绪检测等领域任务常用的基准数据集。

总的来说,imdb 数据集提供了大量真实用户影评的情感标签,是训练和测试情感分类模型的重要公开可获得数据集。它的规模和任务清晰,是 NLP 任务中的一个基准应用。

load_dataset(“wnut_17”)¶

WNUT17数据集是一个新闻领域的命名实体识别数据集,全称为”Workshop on Noisy User-generated Text 2017”。 该数据集的一些关键特征: - 数据来源:Twitter - 包含4个类型的命名实体:位置(location)、人员(person)、组织(organization)和产品(product)。 - 训练集包含3,395条标注过的Twitter消息(tweet)。 - 开发集包含1,000条消息。 - 测试集包含3,857条消息。 - 消息均为非标准英语,包含语法错误、拼写错误和短语缩写。 - 数据集具有一定的噪声,这使其对命名实体识别算法的鲁棒性提出了挑战。 加载该数据集后,得到的wnut变量是一个DatasetDict对象,包含: - train:训练集 - validation:开发集 - test:测试集 每个数据集又包含以下两个字段: - tokens:标注的词语 - ner_tags:每个词的命名实体标签 WNUT17数据集可以用来训练对非标准、嘈杂文本的命名实体识别,评估模型的鲁棒性。它常被用作基准测试数据集。

load_dataset(“squad”)¶

SQuAD数据集是一个阅读理解数据集,全称为Stanford Question Answering Dataset。 squad数据集的主要特征包括: - 数据来源是Wikipedia文章 - 包含10万多个阅读理解题及答案 - 问题是针对给定段落提出的 - 答案是段落的文本片段 - 训练/开发/测试集各5万多个样本 - 采用了 Rajpurkar et al.的常见SQuAD评估指标 这个数据集很好地模拟了机器阅读理解的任务,是阅读理解领域最常用的公开数据集之一。 加载后可直接用于fine-tuning语言表示模型,进行阅读理解任务的模型训练。 squad数据集有助于开发理解文本段落并回答相关问题的AI系统,是语言理解的一个重要benchmark。

load_dataset(“eli5”)¶

eli5数据集是一个问答数据集,全称为”Explain Like I’m 5”。 其主要特征包括: - 来源于Reddit的类似的”explain like I’m 5”子版块的问答帖子 - 包含260,000个问题及详细的答案 - 问题涵盖各个领域,如科学、历史、技术等 - 答案试图以简单易懂的方式解释复杂的概念 - 可用于训练问答系统的读取理解能力 - 回答需要进行推理和概括能力 - 不同于factoid问答,更加复杂和深入 eli5提供了高质量的信息搜索型问答数据,需要模型具备深度语言理解和推理能力,是测试和提升问答系统复杂reasoning能力的有价值数据集。

load_dataset(“opus_books”)¶

opus_books是一个开源的多语言平行语料库,包含不同语言对的书籍数据。 其具体特性包括: - 包含145种语言对的数据 - 总计超过1000本书的内容 - 语料涵盖小说、故事、寓言等文学作品 - 每种语言对平均超过100本书的数据 - 总数据量约1TB - 文件格式为Moses平行语料库的标准格式 - 数据集可通过OPUS网站免费下载

opus_books数据集包含丰富的多语言平行文本,可用于训练机器翻译系统、进行跨语言对比研究等自然语言处理任务。 它覆盖面广、质量高,是语言研究和多语言应用的宝贵资源。加载后可直接用于下游任务的数据准备和模型训练。 (已编辑)

示例:

dataset = load_dataset("opus_books", language_pair=("en", "fr"))

books = load_dataset("opus_books", "en-fr")

load_dataset(“billsum”)¶

billsum数据集是一个英文法案文档摘要数据集,主要有以下特征: - 包含来自美国国会和欧盟委员会的法案文档 - 每个法案文档包含标题、文本内容和手工摘要 - 训练集包含39,357个文档,验证集463个,测试集250个 - 文本内容平均长度约为3,371 tokens - 摘要平均长度约为205 tokens - 文本覆盖多种主题的法案,如经济、医疗、教育等 - 提供原始文本、预处理后文本和摘要3类数据

billsum可用于文本摘要、长文本生成等研究。它提供真实法律文档的核心内容摘要,训练出的模型可以自动生成法律文档摘要。 该数据集质量高,文本具有代表性,是推动法律领域、公共政策等方面文本生成研究的重要资源。

load_dataset(“swag”)¶

SWAG数据集是一份大规模的语言推理数据集。 SWAG(Situations With Adversarial Generations)数据集包含113k个情景描述及4个备选连续(一个正确和三个错误)。该数据集旨在测试语言系统的常识推理能力。 SWAG数据集的一些关键特点: - 情景描述都来自视频字幕 - 每个情景描述都有4个候选语,1个正确,3个错误 - 数据集规模很大,包含113222个训练样本,14823个评估样本 - 涵盖广泛的日常生活情景 - 需要语言模型具有常识推理能力才能判断正确的语义连续性 使用该数据集可以训练和评估自然语言推理模型的性能,考察模型在复杂语义连续任务上的推理和泛化能力。 SWAG数据集来自于2018年CMU发表在EMNLP的论文。该数据集常被用来作为语言理解评估基准之一。

示例:

swag = load_dataset("swag", "regular")

音频¶

load_dataset(“PolyAI/minds14”)¶

MINDS-14是一个针对多模态情感分析任务构建的英文数据集。它包含了来自Youtube视频的14个不同类别的对话,涵盖日常生活各个方面。 该数据集的一些关键统计信息: - 音频长约40小时 - 包含3949段对话 - 平均对话长度约40秒 - 句子级标注的情感标签,包括Positive, Neutral和Negative 3类 研究者利用该数据集可以训练多模态模型来进行视频对话的情感分析,例如从语音和语言两方面判断某句对话的情感极性。 加载后的数据格式是一个字典,主要包含: - audio: 音频waveform - text: 对话转录文本 - emotion: 情感标签 以及一些对话的元信息,如视频ID,发言人ID等。 该数据集适合在多模态情感分析、对话系统等领域进行研究和模型训练。加载后可以直接用于情感分类等任务的Fine-tuning。

图像¶

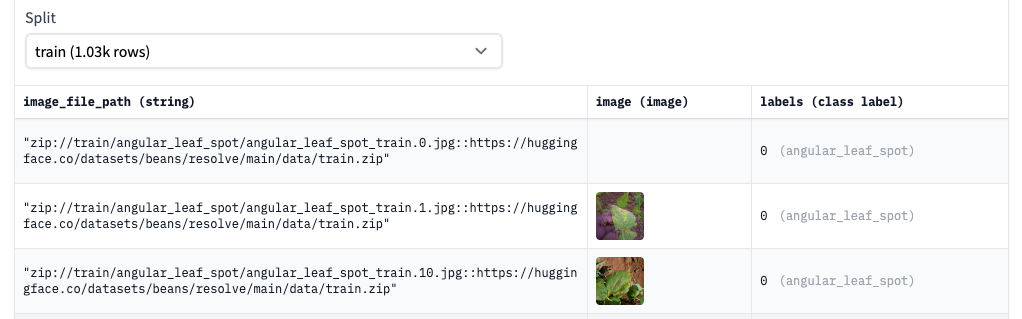

load_dataset(“beans”)¶

Beans leaf dataset with images of diseased and health leaves.

Data Instances:

{

'image_file_path': '/root/.cache/huggingface/datasets/downloads/extracted/0aaa78294d4bf5114f58547e48d91b7826649919505379a167decb629aa92b0a/train/bean_rust/bean_rust_train.109.jpg',

'image': <PIL.JpegImagePlugin.JpegImageFile image mode=RGB size=500x500 at 0x16BAA72A4A8>,

'labels': 1

}

load_dataset(“food101”)¶

Food-101数据集是一个食物图像分类数据集。 Food-101的数据集关键信息: - 包含101个食物类别,总共101000张图片。 - 每类食物大约包含750张训练集图像和250张测试集图像。 - 图像分辨率为256x256像素。 - 图片包含常见的食物照片,如汉堡包、披萨等。 - 数据集采集自foodspotting网站,包含不同场景、角度拍摄的食物图片。 - 提供训练集和测试集划分。 加载后的数据集包含以下内容: - images - 食物图像文件的路径 - labels - 食物类别的标签 - bboxes - 一些图像的边界框标注 该数据集常用于食物识别和图像分类任务,可以用来训练和评估各种图像分类模型的效果。也可用于食物检测模型的预训练。是计算机视觉领域较为常用的食物图像数据集之一。 通过fine-tuning,可以建立一个101分类食物识别模型。

load_dataset(“scene_parse_150”)¶

主要用于场景解析任务,包含150类语义类别的像素级标注图像。其关键信息如下: - 包含20210张图像,分辨率为512x512 - 150个语义类别,涵盖人、动物、交通工具、建筑等常见对象 - 提供像素级标注,每个像素标记了所属的语义类别 - 数据采集自真实场景的街景和室内图像 - 数据来源:ADE20K数据集的子集 - 数据分为训练、验证、测试集 加载的数据包含图像路径image和Segmentation map两部分,map给出了每幅图像每个像素的语义类别。 这个数据集可用于训练像FCN、U-Net等图像语义分割模型,评估其对复杂场景的语义解析能力。 也可用于 few-shot 场景解析任务的研究,或迁移学习到其他相关任务。是计算机视觉领域重要的场景解析数据集之一。

load_dataset(“cppe-5”)¶

CPPE-5是一个用于医用个人防护设备细分类的新数据集。其主要特点为: - 高质量图像和标注(每张图像约4.6个边界框) - 真实生活场景中的图像,不同于当前任何类似数据集 - 大多数图像非标志性,可便于部署到实际环境 支持的任务和排行榜: - 对象检测:可用于训练对象检测模型,具有活跃的排行榜。指标采用COCO检测评估标准,包括不同尺度和IoU阈值下的平均精度(mAP)。 - 该数据集允许研究医用防护设备的细分类,当前其他数据集更侧重大类目标。 - 图像真实而复杂,利于部署实际应用。 总之,CPPE-5是一个高质量的医疗域对象检测数据集,具有研究实际价值的特点,可推动这一领域的技术发展。

示例:

>>> cppe5 = load_dataset("cppe-5")

>>> cppe5

DatasetDict({

train: Dataset({

features: ['image_id', 'image', 'width', 'height', 'objects'],

num_rows: 1000

})

test: Dataset({

features: ['image_id', 'image', 'width', 'height', 'objects'],

num_rows: 29

})

})

示例:

>>> cppe5["train"][0]

{'image_id': 15,

'image': <PIL.JpegImagePlugin.JpegImageFile image mode=RGB size=943x663 at 0x7F9EC9E77C10>,

'width': 943,

'height': 663,

'objects': {

'id': [114, 115, 116, 117],

'area': [3796, 1596, 152768, 81002],

'bbox': [

[302.0, 109.0, 73.0, 52.0],

[810.0, 100.0, 57.0, 28.0],

[160.0, 31.0, 248.0, 616.0],

[741.0, 68.0, 202.0, 401.0]

],

'category': [4, 4, 0, 0]

}

}

MULTIMODAL¶

load_dataset(“lambdalabs/pokemon-blip-captions”)¶

lambdalabs/pokemon-blip-captions是一个针对神奇宝贝(Pokémon)的图像描述数据集,主要由Anthropic的BLIP模型团队构建。以下是其主要特点: - 数据集包含了超过6,000张不同神奇宝贝的图像。 - 每张图像都由人工标注了1-2句描述语料。 - 描述语料专注于图像中的主要神奇宝贝以及其外观特征和属性。 - 数据集覆盖了原版游戏中的151种神奇宝贝。 - 图片各具特色,包含官方插图和玩具模型照等。 - 描述语言流畅自然,数据集质量较高。 - 可用于图像字幕、视觉问答等任务的训练和评测。 - 提供了训练集、验证集和测试集分割。 - 可以通过TensorFlow Datasets加载使用。 - 数据量适中,可快速上手,也可扩充训练。 总体来说,这是一份质量较好的图像描述数据集,主题围绕明确的知识领域,适合作为概念学习和多模态任务的练习数据集,也可以作为更大规模数据集的补充。其作用在于提供高质量的图像-文本训练数据。

load_dataset(“nielsr/docvqa_1200_examples”)¶

数据集 “nielsr/docvqa_1200_examples” 是一个用于文档视觉问答(Document Visual Question Answering,简称 DocVQA)任务的数据集。这个数据集旨在支持模型在理解文档内容并回答与文档相关的问题方面的能力。

数据集中包含约 1200 个样本,每个样本都由以下元素组成:

文档图像:每个样本都有一个文档图像,图像中可能包含文本块、段落、表格、图表等多种排版元素。

问题:每个样本都伴随着一个与文档内容相关的问题,这些问题可能需要对图像中的特定信息进行推理和理解。

答案:每个问题都有一个正确的答案,这个答案可以从文档图像中抽取出来。

这个数据集的目标是促使模型学会从文档图像中抽取信息,然后根据问题理解并回答问题。这对于模拟真实世界中需要从文档中获取信息的情况非常有用,如阅读理解、信息提取等任务。

通过使用 “nielsr/docvqa_1200_examples” 数据集,研究人员和开发人员可以训练和评估模型在文档视觉问答任务上的表现,从而推动文档理解和信息提取领域的研究和应用。

视频¶

sayakpaul/ucf101-subset¶

UCF101官网: https://www.crcv.ucf.edu/data/UCF101.php

sayakpaul/ucf101-subset 是一个在 Hugging Face Hub 上发布的 UCF101 数据集的子集。 UCF101 是一个行为识别(action recognition)的标准基准数据集,由佛罗里达大学收集和标注。该数据集包含 13320 个视频片段,涵盖 101 个人类行为类别,如篮球运球、跳舞、爬楼梯等。 该数据集子集的主要信息如下: - 包含 UCF101 数据集的一个子集,视频数量更少但保留了所有 101 个行为类别。 - 视频格式为 AVI,分辨率为 320x240 像素。 - 提供了视频文件的路径列表和类别标签。 - 类别均匀分布,每个类别约有 100 个视频片段。 - 文件总大小约为 5.5GB。 这个子集的目的是提供一个小规模、易处理、包含多类别并保持类别均衡的行为识别数据集,用于算法开发、快速验证等目的。它保留了 UCF101 数据集多样性的同时,文件容量小,使用门槛更低。 总之,sayakpaul/ucf101-subset是一个行为识别领域常用的小数据集,适用于算法研究和模型训练等用途。

示例:

from huggingface_hub import hf_hub_download

hf_dataset_identifier = "sayakpaul/ucf101-subset"

filename = "UCF101_subset.tar.gz"

file_path = hf_hub_download(repo_id=hf_dataset_identifier, filename=filename, repo_type="dataset")

import tarfile

with tarfile.open(file_path) as t:

t.extractall(".")